Les màquines no saben decidir

Els algoritmes que governen la intel·ligència artificial i els robots s’han de sotmetre a regles ètiques i morals

BarcelonaLes màquines, tot i que pugui costar de creure, estan sotmeses a principis morals i ètics. I, com més sofisticades siguin, cosa que implica més graus de llibertat i més autonomia, més elevat és el component ètic. És el cas de robots i també de la intel·ligència artificial. En bona mesura, que es respectin aquests principis depèn de la seva programació, és a dir, dels algoritmes que es creen perquè les màquines facin la funció per a la qual estan dissenyades. Dit d’una altra manera, de la intervenció humana en la seva concepció. L’estudi d’aquestes normes i principis ètics, que va molt més enllà del que Isaac Asimov definia el 1950 com que de cap de les maneres un robot podia fer mal a un humà, rep el nom de roboètica. Una disciplina que creix cada dia que passa i que té en la programació de l’algoritme el seu punt central.

Decidir en cas de conflicte

Ramon López de Mántaras, professor d’investigació al CSIC i exdirector del pioner Institut d’Investigació en Intel·ligència Artificial (IIIA), és un dels investigadors que més han reflexionat sobre aquest tema a casa nostra. “¿Com ensenyem a un cotxe autònom si cal girar cap a la dreta o cap a l’esquerra en cas de conflicte?”, pregunta d’entrada. Per a l’expert, aquesta mena de vehicles no són altra cosa que “robots amb rodes” governats amb intel·ligència artificial. “Els podem ensenyar a respectar les normes de trànsit, però no està clar que sàpiguen respondre adequadament a un incident imprevist”. Per exemple, davant d’un gran bassal d’aigua, on els humans frenaríem de manera intuïtiva, o les alternatives davant d’un xoc imminent. “¿Atropella un animal o esquiva un altre cotxe? I si és una persona?”, diu. I afegeix: “Si no condueixes ni tens la possibilitat de fer-ho, qui se’n fa responsable?”

Aquest és un dels molts dilemes tècnics amb càrrega ètica que han de resoldre sovint els programadors d’algoritmes. N’hi ha d’altres de tant o més sagnants. Un dels més rellevants té a veure amb el biaix. “El programador viu en un context, una cultura o unes circumstàncies concretes”, resumeix López de Mántaras. Per tant, és possible que introdueixi valors que no són universals. Podria ser el cas de paràmetres amb biaix racista, de gènere o basats en prejudicis socials. El resultat d’aquesta programació inclourà el biaix. “La culpa no serà de la màquina ni de l’algoritme, sinó del programador -diu-. Alguns programes suposadament avançats etiqueten com a goril·les persones d’origen africà”.

El problema s’agreuja quan l’algoritme és l’encarregat de fer una selecció de personal, predir una condemna o revisar una pena, com ja està passat en diferents països. O en la tria de treballadors acomiadats d’una gran empresa o, molt més greu, si és el responsable de determinar l’objectiu d’armes letals autònomes, com ho són els drons d’ús militar.

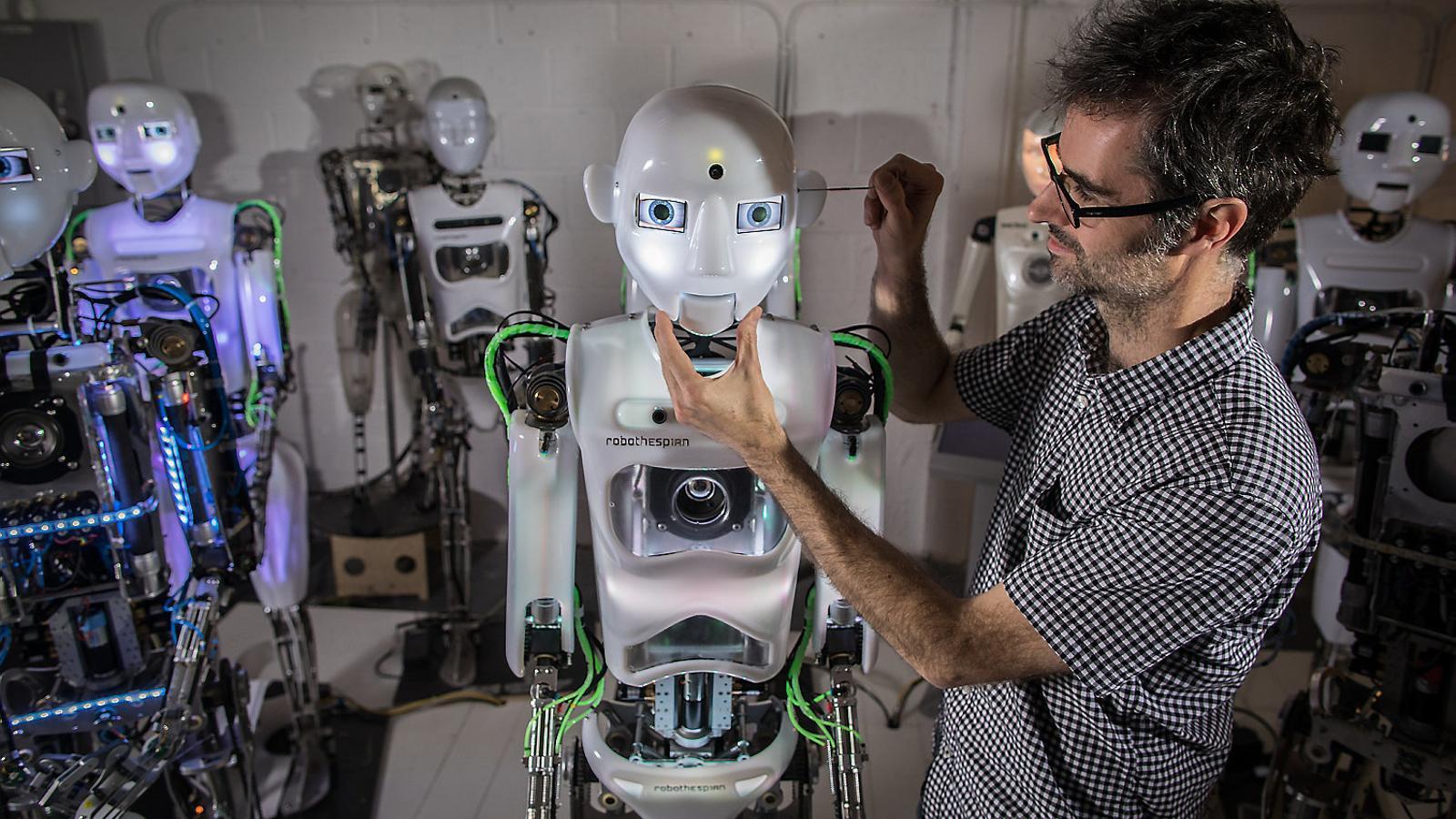

Robots? Amb cos, sisplau

Aquests ginys informàtics i molts d’altres de programats amb intel·ligència artificial es tendeixen a anomenar robots. En essència, perquè estan automatitzats, disposen d’un cert grau d’autonomia i tenen la capacitat de millorar les seves prestacions a mesura que adquireixen coneixements. Però no tothom hi està d’acord. Paul Verschure, professor ICREA a l’Institut de Bioenginyeria de Catalunya (IBEC), raona que es pot entendre aquesta denominació com a metàfora, però no pas com una realitat. “Un robot precisa d’un cos, sigui quina sigui la seva forma i siguin quins siguin els algoritmes que governen la seva funcionalitat”, diu. Aquesta forma pot ser humanoide o, al contrari, no tenir-hi res a veure, com passa amb la majoria de robots industrials. Que tingui forma humana té molt a veure, segons Verschure, amb una capacitat tan essencial com la comunicació. “En determinades circumstàncies, també en les assistencials, la forma i els moviments humanoides faciliten la interacció entre els humans i les màquines”, diu. Creu que aquest aspecte pot ajudar a establir relacions de confiança, especialment en pacients d’edat avançada o amb deficiències cognitives. Però el debat ètic està obert. Hi ha qui considera que aquest punt pot generar sentiments d’addicció o de substitució. Òbviament, els algoritmes han de tenir present aquesta limitació.

Sigui com sigui, i malgrat que tendim a pensar en els robots com a eines que fan tasques repetitives i complexes, perilloses o de caràcter assistencial, i que tenen com a primer principi no danyar els humans, la realitat és que encara estem molt lluny, diu Verschure, que siguin una realitat fefaent. Probablement, diu López de Mántaras, s’ha avançat més en la generació d’algoritmes que no pas en la capacitat de dotar d’autonomia els robots. “Tret dels que treballen en l’entorn de l’automoció o empreses amb necessitats similars, la resta són molt poc eficients i la seva despesa energètica és altíssima”, diu l’expert de l’IBEC. “Pensar en robots sofisticats i altament autònoms és encara ciència-ficció”, afegeix. Una fantasia mecànica però una realitat més pròxima en termes d’intel·ligència artificial i generació d’algoritmes que ajuden en la presa de decisions i que es té tendència a fer-los decidir per nosaltres. Però com diu López de Mántaras, “les màquines no saben decidir”. Per això calen regulacions legals i ètiques.